Professional Documents

Culture Documents

Estocasticos

Uploaded by

Cita Cita Mar MonCopyright

Available Formats

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Available Formats

Estocasticos

Uploaded by

Cita Cita Mar MonCopyright:

Available Formats

MODELOS ESTOCSTICOS

Introduccin a los

procesos estocsticos

Descripcin de procesos

estocsticos

Procesos Markovianos

Procesos de renovacin

Cadenas de Markov

Componentes de una cadena de

Markov

Ecuaciones Chapman-

Kolmogorov

Clasificacin de estados y

cadenas

Cadenas de Markov finitas

Finitas con estados

recurrentes y transitorios

Finitas irreductibles con

estados ergdicos

Cadenas de Markov con estados

infinito numerables

Aplicacin de cadenas de

Markov en sistemas de

inventarios, produccin y

mantenimiento

Procesos de Markov

Proceso de Poisson

Proceso de nacimiento y muerte

Propiedades generales de

procesos markovianos con

estados discretos

Procesos markovianos con

recompensa

Procesos markovianos con

recompensa y descuento

MODELOS ESTOCSTICOS

BIBLIOGRAFA BSICA:

Investigacin de operaciones. Hillier, Frederick

Stanton y Lieberman Gerald.

McGraw-Hill

Investigacin de operaciones: una introduccin. Taha,

Hamy A. Prentice-Hall

BIBLIOGRAFA COMPLEMENTARIA:

Applied Probability Models. Minh, Do Le Paul. Edit

Duxbury Press

Markov Chains. Norris, James R. Edit Cambridge

University Press

PROCESOS ESTOCSTICOS

PROCESO ESTOCSTICO

Es aquel en el que se representan todos y

cada uno de los pasos necesarios para

realizar una actividad, adems de las

formas o maneras en que cada uno de los

pasos puede ser llevado a efecto y sus

respectivas probabilidades,

Es cualquier proceso en el que se

involucren probabilidades.

PROCESOS DE MARKOV O MARKOVIANOS

Usos de los procesos de Markov

Operativilidad de maquinaria (Una mquina que

funcione en el siguiente periodo).

Fidelidad del consumidor (Que la clientela

permanezca o cambie de proveedor)

Anlisis de cuentas por cobrar

Cambio de estados en los negocios

MARKOV PROPORCIONA

Informacin acerca de la probabilidad de cada

estado despus de una gran cantidad de

transiciones o periodos.

Probabilidades a lo largo del tiempo o el estado

en el que terminarn los acontecimientos.

Idea del camino a tomar para alcanzar objetivos y

metas.

CLASIFICACIN DE PROCESOS MARKOVIANOS

Se clasifican de acuerdo al tipo de espacio y tipo

de parmetro:

Segn el espacio de estados:

Espacio Discreto: el proceso recibe el nombre de

Cadena de Markov,

Espacio continuo: se conoce como Proceso de Markov.

Segn el parmetro temporal:

Procesos o cadenas de Tiempo Continuo

Procesos o cadenas de Tiempo Discreto.

8

PROCESO ESTOCSTICO

Se define como un proceso estocstico con la

propiedad de que para cualquier conjunto sucesivo de

n tiempos t

1

< . . . t

n

se tiene

Esto es la densidad de probabilidad condicionada a t

n

dada el valor y

n-1

a t

n-1

esta unvocamente

determinada y no esta afectada por lo que ocurre a

tiempos anteriores. A P

1|1

se le llama probabilidad de

transicin.

PROCESO ESTOCSTICO

El proceso de Markov esta completamente

determinado por dos funciones

Se define como un proceso estocstico con la

propiedad de que para cualquier conjunto

sucesivo de n tiempos t

1

< . . . t

n

se tiene

Esto es la densidad de probabilidad condicionada

a t

n

dada el valor y

n-1

a t

n-1

esta unvocamente

determinada y no esta afectada por lo que ocurre

a tiempos anteriores. A P

1|1

se le llama

probabilidad de transicin.

PROCESOS ESTOCSTICOS

El espacio de estados S de un proceso estocstico

es el conjunto de todos los posibles valores que

puede tomar dicho proceso:

( ) { } O e . e = e e T t X S

t

|

EJEMPLOS DE PROCESOS ESTOCSTICOS

1. Serie mensual de ventas de un producto

2. Estado de una mquina al final de cada

semana (funciona/averiada)

3. N de clientes esperando en una cola cada 30

segundos

4. Marca de detergente que compra un

consumidor cada vez que hace la compra.

5. N de unidades en almacn al finalizar la

semana

PROCESOS ESTOCSTICOS

Un proceso estocstico es

una familia de variables

aleatorias definida sobre

un espacio de

probabilidad. Es decir:

{ } T t X

t

e 9 O , :

( ) ( ) t X X

t

, e e e =

Un sistema informtico

complejo se caracteriza

por demandas de carcter

aleatorio y por ser

dinmico

Se necesita una

herramienta que modele

procesos aleatorios en el

tiempo, y para ello se

usan los procesos

estocsticos

Un proceso estocstico es

una familia de variables

aleatorias parametrizadas

por el tiempo

PROCESOS ESTOCSTICOS

Tendremos que X es una funcin de dos argumentos.

Fijado e=e

0

, obtenemos una funcin determinista (no

aleatoria):

( ) 9 T X : ,

0

e

( )

0

,e t X t

Asimismo, fijado t=t

0

, obtenemos una de las

variables aleatorias de la familia:

( ) 9 O : ,

0

t X

( ) e e ,

0

t X

EJEMPLO 1

En un lote de autos usados, el 25% son de la

marca Ford, el 45% son Chevrolet y el 30% son

Chrysler, de los cuales, 2 de cada 8 autos Ford

son estndar, 1 de cada 10 autos Chevrolet son

estndar y 2 de cada 10 autos Chrysler son

tambin estndar, un cliente compra un auto de

este lote,

a. cul es la probabilidad de que el auto

seleccionado por el cliente sea estndar?,

b. cul es la probabilidad de que haya

seleccionado un auto Chevrolet estndar?,

c. cul es la probabilidad de que el auto

seleccionado sea Ford o Chrysler

automtico?

Autos

usados

25 % Ford

Standard 2/8

Automtico 6/8

45 %

Chevrolet

Standard 1/10

Automtico 9/10

30 %

Chryler

Standard 2/10

Automtico 8/10

a) P(seleccionar un auto estndar) = p(seleccionar un

Chevrolet o Chrysler o Ford estndar) = p(ChS) + p(ChrS)

+ p(FS)

= p(Ch)p(S|Ch) + p(Chr)p(S|Chr) + p(F)p(S|F)

= 0.45*1/10 + 0.30*2/10 + 0.25*2/8

= 0.045 + 0.06 + 0.0625

= 0.1675

b) p(seleccionar un Chevrolet estndar) = 0.45*1/10 = 0.045

c) p(seleccionar un Ford o Chrysler automtico) = p(FA) +

p(ChrA)

= p(F)p(A|F) + p(Chr)p(A|Chr)

= 0.25*6/8 + 0.30*8/10

= 0.1875 + 0.24 = =0.4275

EJEMPLO 2

En un lote de produccin se tienen 150

artculos, de los cuales 30 son del tipo A, 60 del

tipo B y 60 del tipo C, de los que el 15% de los

productos del tipo A, 20% de los productos del

tipo B y 5% de los productos del tipo C, no

cumplen con las especificaciones, si se

selecciona un producto de este lote al azar,,

a. Determine la probabilidad de que el

producto seleccionado no cumpla con las

especificaciones ,

b. Si el producto seleccionado no cumple con

las especificaciones, cul es

c. cul es la probabilidad de que un producto

cumpla con las especificaciones y sea del

tipo B?

Lote de

produccin

A 40/150

No cumple 15 %

Cumple 85 %

B 60/150

No cumple 20 %

Cumple 80 %

C 60/150

No cumple 5 %

Cumple 95 %

a) p(producto seleccionado no cumpla con las

especificaciones) = 40/150*0.15 + 60/150*0.20 +

60/150*0.05

= 0.04 + 0.08 + 0.02

= 0.14

b. E = evento de que el producto seleccionado no cumpla

con las especificaciones

B = evento de que el producto seleccionado sea del tipo

B

p(B|E) = p(BE)/p(E) = (60/150*0.20)/0.14 = 0.08/0.14=

0.57143

c. p(cumpla con las especificaciones y sea del tipo B) =

60/150*0.8 = 0.32

CADENAS DE MARKOV

Las cadenas de Markov son modelos

probabilsticos que se usan para predecir la

evolucin y el comportamiento a corto y a largo

plazo de determinados sistemas.

Ejemplos: reparto del mercado entre marcas;

dinmica de las averas de mquinas para decidir

poltica de mantenimiento; evolucin de una

enfermedad,

Una Cadena de Markov (CM) es:

Un proceso estocstico

Con un nmero finito de estados (M)

Con probabilidades de transicin estacionarias

Que tiene la propiedad markoviana

Propiedad Markoviana

PROPIEDADES MARKOVIANAS

Propiedad 1:

El tiempo en que el proceso se mantiene en un estado

particular debe ser sin memoria.

En el caso de un proceso de parmetros continuos sta

distribucin es una exponencial, en la cual su parmetro

puede variar a travs de los distintos estados.

En el caso de un proceso de parmetros discretos sta

distribucin es una geomtrica, al igual que en el caso

continuo su parmetro puede variar a travs de los

distintos estados.

Un proceso estocstico tiene la

propiedad markoviana s las

probabilidades de transicin en un

paso slo dependen del estado del

sistema en el perodo anterior

(memoria limitada)

PROPIEDADES MARKOVIANAS

Propiedad 2:

La transicin al siguiente estado slo depende de las

condiciones del estado actual.

Definicin formal :

Un proceso estocstico con:

- t

1

<t

2

<t

3

<.....<t

n

<t

n+1

- {x

1

,x

2

,x

3

,.....,x

n

,x

n+1

}

Cumple la propiedad 2 si:

P[X(t

n+1

) = x

n+1

| X(t

1

)=x

1

, X(t

2

)=x

2

,......, X(t

n

)=x

n

]

=P[X(t

n+1

) = x

n+1

| X(t

n

)=x

n

]

P

(n)

es la matriz de transicin en n pasos, de orden (M+1)x(M+1)

LAS CADENAS DE MARKOV SE CONSIDERAN COMO UN

CASO PARTICULAR DE LOS MODELOS DE MARKOV

Tipos de modelos de Markov:

Procesos de Markov (Modelos semi-markovianos):

Las probabilidades de transicin entre estados pueden variar a

medida que transcurren ms ciclos

Ejemplo: para modelizar la esperanza de vida, el riesgo de

muerte aumenta con la edad

Cadenas de Markov: Las probabilidades de transicin

se suponen constantes a lo largo del tiempo

Las cadenas de Markov poseen espacio de estados

discreto, denominados: {E

0

, E

1

, E

2

, ...}, simplificando

la notacin, se asocian a los nmeros naturales; para el

caso general el entero i representa al estado E

i

.

El estado en que se encuentra la cadena en un tiempo

n se denota como:

X

n

=i , estar en el estado i en el tiempo n.

La probabilidad de transicin para ir desde el estado i

al estado j en un paso es:

P

ij

= P[X

n+1

=j | X

n

=i]

En general P

ij

(n) depende de n.

Cuando P

ij

(n) no depende de n, la probabilidad de

transicin desde el estado i al j no varia en el tiempo.

28

Cadenas de Markov discretas

Un conjunto finito de M estados, exhaustivos y

mutuamente excluyentes (ejemplo: estados de la

enfermedad)

Ciclo de markov (paso) : periodo de tiempo

que sirve de base para examinar las

transiciones entre estados (ejemplo, un mes)

Probabilidades de transicin entre estados,

en un ciclo (matriz P)

Distribucin inicial del sistema entre los M

estados posibles

Elementos de una cadenas de Markov

Las probabilidades de

transicin P

ij

se pueden

representar en una matriz

cuadrada llamada Matriz de

Probabilidad de Transicin de

la cadena.

30

|

|

|

|

|

|

.

|

\

|

=

KK K

K

P P

P P

P P P

0

11 10

0 01 00

P

Desde el

estado i

Hasta el

estado j

P

ij

1 2 3 4 5

1

2

3

4

5

P =

Tambin se puede

representar, el

diagrama de estados

puede representarse en

forma matricial.

2.

Esto significa que para cada estado la suma de todas las

probabilidades de transicin sean 1.

Adems, dentro de cada fila los valores son no negativos, estos

valores estn entre 0 y 1. La suma de los valores de la fila es 1,

luego, se dice que la matriz es de tipo estocstica.

.... , 2 , 1 , 0 , ; 0 1 = > > j i T

ij

=

= =

0

.... , 2 , 1 , 0 ; 1

j

ij

i para T

Cadenas de Markov discretas

Las propiedades de la matriz de transicin de probabilidad son:

1.

Como cada elemento de la matriz representa una

probabilidad, sta debe tener un valor entre 0 y 1.

Cadenas de Markov discretas

Dada , que corresponde a la probabilidad de transicin del

estado i al estado j en 1 paso, se puede generalizar a que

representa la probabilidad de ir del estado i al estado j en n

transiciones como:

ij

T

ij

T

Adems i,j pertenecen al espacio de estados

0 }; | {

0

> = = = n i X j X T T

n

n

ij

Si las probabilidades de transicin son estacionarias, podemos

generalizar la expresin anterior a:

Esto representa la probabilidad de pasar desde el estado i al

estado j en n pasos, partiendo desde el estado i, sin importar

como se lleg a este estado (en general, en m pasos).

0 }; | { > = = =

+

n i X j X T T

m m n

n

ij

CADENAS DE MARKOV

Las cadenas de Markov y los procesos de Markov

son un tipo especial de procesos estocsticos que

poseen la siguiente propiedad:

Propiedad de Markov: Conocido el estado del

proceso en un momento dado, su comportamiento

futuro no depende del pasado. Dicho de otro

modo, dado el presente, el futuro es

independiente del pasado

PROBABILIDADES DE TRANSICIN

Las Cadenas de Markov estn completamente

caracterizadas por las probabilidades de transicin en

una etapa,

T t S j i

i X

j X

P

t

t

e e

(

=

=

+

, , ,

1

ij

t

t

q

i X

j X

P T t S j i =

(

=

=

e e

+1

, ,

Las Cadenas de Makov homogneas en el tiempo,

son aquellas en las que

donde q

ij

se llama probabilidad de transicin en una

etapa desde el estado i hasta el estado j

MATRIZ DE TRANSICIN

Los q

ij

se agrupan en la denominada matriz de

transicin de la CM:

( )

S j i

ij

q

q q q

q q q

q q q

T

e

=

|

|

|

|

|

.

|

\

|

=

,

22 21 20

12 11 10

02 01 00

... ... ... ...

...

...

...

You might also like

- Mecánicas Matricial y OndulatoriaDocument39 pagesMecánicas Matricial y OndulatoriaKarelBRGNo ratings yet

- Modulo 2 Quimica DecimoDocument6 pagesModulo 2 Quimica DecimoNorvey Valencia LopezNo ratings yet

- Mesa Cuantica 3Document3 pagesMesa Cuantica 3Juan Ignacio SublonNo ratings yet

- Ficha Tecnica Electr RuralDocument6 pagesFicha Tecnica Electr RuralTahnee BaltaNo ratings yet

- S-1 Lab 1 Precisión de Las MedidasDocument14 pagesS-1 Lab 1 Precisión de Las MedidasANA LETICIA VAZQUEZ NAVARRO100% (1)

- Guía Ley de Gravitacion, Fuerza Elastica y Fuerza de RoceDocument16 pagesGuía Ley de Gravitacion, Fuerza Elastica y Fuerza de RoceCartas Myl Chillan Cartas0% (1)

- ESTADÍSTICA I Clases 3Document13 pagesESTADÍSTICA I Clases 3Gregorio MarquezNo ratings yet

- Presentacion Sobre CorrosionDocument32 pagesPresentacion Sobre Corrosiongacm98No ratings yet

- Manual de Las CajasDocument135 pagesManual de Las Cajasmena_omar3677100% (3)

- Cantidad de Movimiento Lineal y Colisiones Parte 1Document34 pagesCantidad de Movimiento Lineal y Colisiones Parte 1Emily AldanaNo ratings yet

- Notas Explicativas Seccion 11Document178 pagesNotas Explicativas Seccion 11xperialsmmNo ratings yet

- Decoder Doehler & Haass Manual DH21A I Mes EsDocument44 pagesDecoder Doehler & Haass Manual DH21A I Mes EsGuillermo LlopisNo ratings yet

- Ejercicio 1 - Manejo de Documentación ASME VIIIDocument3 pagesEjercicio 1 - Manejo de Documentación ASME VIIIStefanoNo ratings yet

- Notice Chauffe Eau Elec 10L 150L FR88 DocpdfDocument15 pagesNotice Chauffe Eau Elec 10L 150L FR88 DocpdfAlpha1201No ratings yet

- Proyecto Fclds Campo ItauDocument46 pagesProyecto Fclds Campo ItauDrillerman Gonzales Ovando100% (1)

- EFinitos - Sesion - 02 - 2 - Metodo - VariacionalDocument50 pagesEFinitos - Sesion - 02 - 2 - Metodo - VariacionalFernando Vilavila NoriegaNo ratings yet

- Laboratorio 2.Document4 pagesLaboratorio 2.Marifer FloresNo ratings yet

- Trilha Ivan - El Poder de La MenteDocument34 pagesTrilha Ivan - El Poder de La MenteJosé María García Nieto100% (1)

- Unidad 2: Tarea 2 - Límites y ContinuidadDocument13 pagesUnidad 2: Tarea 2 - Límites y ContinuidadSeñor XNo ratings yet

- Utc Exam Parcial Fis Tema 1Document5 pagesUtc Exam Parcial Fis Tema 1Flavio LópezNo ratings yet

- Proyecto SiemensDocument47 pagesProyecto SiemensPablo LayanaNo ratings yet

- Taller de Preparacion para La Sintesis de 4 Periodo - Grado QuintoDocument3 pagesTaller de Preparacion para La Sintesis de 4 Periodo - Grado Quintodiana_cardenas_9No ratings yet

- Electrónica de Potencia U5Document10 pagesElectrónica de Potencia U5MarcoLunaRiosNo ratings yet

- Generador Eolico - Informe TerminadoDocument17 pagesGenerador Eolico - Informe TerminadoGonzalo William Pereyra BarretoNo ratings yet

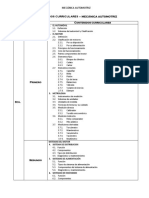

- Contenidos Curriculares Mecanica AutomotrizDocument3 pagesContenidos Curriculares Mecanica Automotrizmarcos100% (1)

- Practica Motor Fase HendidaDocument5 pagesPractica Motor Fase HendidaSantiago MéndezNo ratings yet

- Grabar Cds y DVDS, Unidad de CD-romDocument36 pagesGrabar Cds y DVDS, Unidad de CD-romAlondra De CossNo ratings yet

- Mecánica de Materiales EjemplosDocument12 pagesMecánica de Materiales EjemplosLeon PrtNo ratings yet

- Etapa 3 FisicaDocument8 pagesEtapa 3 FisicaBrissa TCNo ratings yet

- Laboratorio 3 (E. Digital)Document16 pagesLaboratorio 3 (E. Digital)NiltonRamírezNo ratings yet